Når du tar tak i noe, gjør hånden det meste av arbeidet. Hjernen din sier bare "gå, ikke bekymre deg for hvordan det skjer." Men med en protese, til og med den mest avanserte, krever den handlingen mye mer intensjonalitet. Som et resultat forlater mange pasienter sine moderne lemmer.

Relatert innhold

- Hvordan hacking av nevrale nettverk kan hjelpe amputeres feilfritt å sprekke et egg

- Det er enkelt å få protesen, sammenlignet med å få den til å gjøre det du vil

Moderne protetikk mottar kommandoer i form av elektriske signaler fra musklene de er festet til. Men selv de beste protesene kan ikke mye ennå. Brukere trenger en lang treningsperiode for å bli vant til lemmet. De kan ofte bare bevege seg på begrensede måter, og brukere må bytte mellom grep manuelt for å utføre forskjellige oppgaver - for eksempel å åpne en dør kontra klemme og vri en nøkkel. Alt i alt betyr det at hånden ikke kan fungere sømløst med hjernen.

Et verktøy som kan bidra til å løse dette problemet, er datasyn. Forskere ved Newcastle University monterte et webkamera på en protesehånd, koblet det til et dypt lærende nevralt nettverk og ga enhetene til to amputerte hvis armer hadde blitt amputert over håndleddet, men under albuen. Datamaskinen brukte kameraet for å se hva brukeren var ute etter og automatisk justere protesens grep.

Resultatene har så langt vært lovende. I en artikkel i Journal of Neural Engineering rapporterte teamet fra Newcastle at brukerne hadde suksessrater over 80 prosent for å plukke opp og flytte objekter.

"Hvis vi kan forbedre det, få hundre prosent, ville det være mye mer pålitelig å bruke hånden til amputerte, " sier Ghazal Ghazaei, doktorgradsstudent ved Newcastle og hovedforfatter av papiret. "Hvis det kommer til å være brukt i det virkelige liv, bør det være feilfritt. ”

Enheten var i seg selv en protese som heter en i-lem ultra, og webkameraet var en billig og billig Logitech Quickcam Chat. Den virkelige nyvinningen var hvordan Ghazaei's team utviklet et datamaskinlæringsskjema for å bruke informasjonen fra webkameraet.

Programvaren gjenkjenner mønstre i form av objektet som skal løftes og klassifiserer dem i kategorier basert på grepet den trenger for å effektivt gripe dem. For å lære datamaskinen denne teknikken matet Ghazaei den 72 bilder hver, tatt i trinn på 5 grader, av 500 objekter. Programvaren filtrerer objektene etter funksjonene deres, og lærer gjennom prøving og feiling hvilke som faller inn i hvilke kategorier.

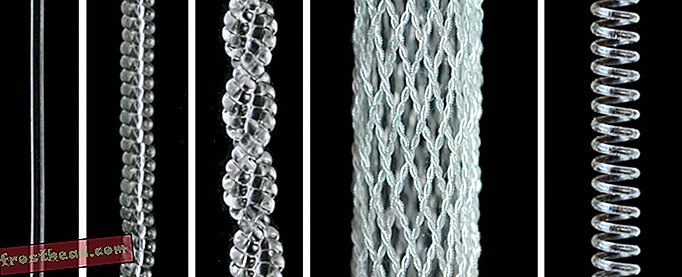

Når protesen blir presentert med et objekt, klassifiserer nettverket deretter lavoppløsningsbildet basert på dets brede, abstrakte form. Det trenger ikke være noe systemet har sett før - den generelle formen på objektet er nok til å fortelle hånden hvilket grep som skal brukes. Ghazaei og team brukte fire grepstyper, inkludert klype (to fingre), stativ (tre fingertupper), nøytral palmar (som å ta tak i en kaffekopp) og uttalt palmar (der håndflaten vender nedover).

Datasyn er blitt brukt på robothender før, både i proteser og industriroboter. Men slik innsats har enten involvert gjenstander av standard størrelse og form, som i et produksjonsmiljø, eller langsommere algoritmer. Systemet utviklet i Newcastle var i stand til å gå gjennom denne prosessen raskt nok til å klassifisere objektene riktig i 450 mikrosekunder, eller rundt 1/2000 sekund av et sekund. "Hovedforskjellen er tiden det tar å få et grep og gjøre oppgaven, " sier Ghazaei. “For noen av dem er det omtrent fire sekunder, og noen av dem trenger flere øyeblikksbilder. For oss er det bare ett øyeblikksbilde, og det er veldig raskt. ”

Effektene av denne teknologien går langt utover å hente husholdningsartikler. Bildesystemer kan hjelpe protese ben å vite hvor langt de er fra bakken, og tilpasse seg for eksempel. Det som begge tilfeller har felles, er et robotsystem som fungerer sammen med hjernen.

"Hovedideen er å ha et samspill mellom robotapparatet og det menneskelige, og legge til litt intelligens i robotsystemet, " sier Dario Farina, professor i neurorehabiliteringsteknikk ved Imperial College London, hvis laboratorium studerer nevromuskulære grensesnitt for kropper og hjerner og enhetene de kobler til.

"Det er ikke bare pasienten som kontrollerer protesen med hjernen og gjennom det nevrale grensesnittet, men det er også pasienten som blir hjulpet av en andre intelligent enhet, som er montert på protesen og som kan se miljøet, " sier Farnia, som ikke var involvert i Newcastle-studien. "Hovedutfordringen i dette er egentlig å kunne dele kontrollen mellom det menneskelige og etterretningssystemet."

Det er et tidlig inngrep i sammenslåing av kunstig intelligens med hjernen, og beskriver hvilke handlinger som fungerer best for hver uten å skape konflikt. Ghazaei har fått dette problemet; hun jobber fremdeles med å håndtere hvor mye av bred bevegelse som styres av protesens datamaskin, kontra brukerens handlinger. Akkurat nå peker brukeren protesen mot gjenstanden, induserer den til å ta et bilde, og deretter velger armen grepet og griper tak.

Det er bare en av mange gjenværende utfordringer. Akkurat nå kan ikke systemet forstå lange objekter som strekker seg utenfor synet. Det har problemer med overfylt bakgrunn. Noen ganger tolker det et lengre borte objekt som et mindre, nærmere objekt. Og Ghazaei sier at å øke antallet grepstyper til 10 eller 12 er et annet mål. Men allerede, sier hun, satte de to brukerne i rettssaken pris på økningen i ytelsen og enkelheten det gir til den grunnleggende handlingen for å hente noe.