Avhengig av hvordan du teller dem, er det menneskelige ansiktet drevet av mellom 23 og 43 muskler, hvorav mange festes til huden, og tjener ingen åpenbar funksjon for å overleve. En romvesen som undersøker et menneskelig eksemplar isolert ville ikke vite hva de skulle lage av dem. Når du drar i pannen, øyenbrynene, leppene og kinnene, kringkaster musklene et vell av informasjon om vår emosjonelle tilstand, interesse og årvåkenhet. Det er et bemerkelsesverdig effektivt kommunikasjonsmiddel - nesten øyeblikkelig, vanligvis nøyaktig, overskridende de fleste språk- og kulturhindringer. Men noen ganger går dataene tapt, ignorert eller tolket feil. Hvis en tømmerhogger smiler i skogen med ingen rundt seg for å se ham, var han faktisk lykkelig?

Fra denne historien

[×] STENGT

Så lange uttrykksikoner. Forskeren utvikler teknologi som kan oppdage og lese uttrykkene våre

Video: Smithsonian Ingenuity Awards 2015: Rana el Kaliouby

Relaterte leser

Emosjonell intelligens: Hvorfor det kan saken mer enn IQ

KjøpeRana el Kaliouby hater å se at informasjon går til spill. Når jeg møter el Kaliouby på det lille kontoret hennes i Waltham, Massachusetts, ser jeg henne trekke sammen sin store muskel med zygomaticus, løfte munnvikene og orbicularis oculi, og knirre de ytre hjørnene av øynene. Hun smiler, og jeg utleder at hun ønsker meg velkommen, før hun til og med får ordet "hei." Men mange sosiale utvekslinger i dag finner sted uten sanntid interaksjon ansikt til ansikt. Det er her el Kaliouby, og selskapet hennes, kommer inn.

El Kaliouby, som er 37, smiler ofte. Hun har et rundt, trivelig, uttrykksfullt ansikt og en pålitelig måte, og binder sin stilling som medstifter av en raskt voksende teknisk start-up - en anti-Bezos, en un-Zuckerberg. Selskapet hennes, Affectiva, som hun grunnla i 2009 med en daværende kollega ved MIT Media Lab, Rosalind Picard, inntar en posisjon i forkant av teknologien for å bruke datamaskiner for å oppdage og tolke menneskelige ansiktsuttrykk. Dette feltet, kjent som “affektiv databehandling”, søker å tette kommunikasjonsgapet mellom mennesker og maskiner ved å legge til en ny modus for samhandling, inkludert smil, smirks og hevede øyenbryners språk. "Forutsetningen for hva vi gjør er at følelser er viktige, " sier el Kaliouby. Følelser forstyrrer ikke vår rasjonelle tenkning, men veileder og informerer om den. Men de mangler fra vår digitale opplevelse. Smarttelefonen din vet hvem du er og hvor du er, men den vet ikke hvordan du har det. Vi har som mål å fikse det. ”

Hvorfor trenger smarttelefonen din å vite hvordan du har det? El Kaliouby har en rekke svar, alt basert på den tilsynelatende grenseløse integrasjonen av datamaskiner i rutinene i hverdagen vår. Hun ser for seg “teknologi for å kontrollere belysning, temperatur og musikk i hjemmene våre som svar på humøret vårt”, eller apper som kan tilpasse innholdet i en film basert på underbevisste reaksjoner på den mens du ser. Hun ser for seg programmer som kan overvåke uttrykket ditt mens du driver og advarer om uoppmerksomhet, døsighet eller sinne. Hun smiler for omtale av favorittideen sin - "et kjøleskap som kan føles når du er stresset og låser iskremen."

Spesielt tror hun Affectiva, og teknologien det hjelper for å innlede mainstream, vil være en velsignelse for helsevesenet. En forsker som tester et nytt medikament, eller en terapeut som behandler en pasient, får bare tilbakemeldinger med intervaller, underlagt alle problemene med selvrapportering - det ubevisste ønsket om å behage legen, for eksempel, eller selektiv tilbakekalling som favoriserer de siste minner . El Kaliouby ser for seg et program som kjører i bakgrunnen for motivets bærbare eller telefon som kan utarbeide en øyeblikkelig oversikt over humøret hans i løpet av en periode (en dag, en måned) og korrelere den med tid eller noe annet enheten din kan måle eller spore. "Det trenger ikke en gang å være en del av et behandlingsopplegg, " tenker hun. "Du kan bare ha den på telefonen din, og den forteller deg at hver gang X-anrop har et negativt uttrykk, og det forteller deg noe du kanskje ikke har visst."

Abonner på Smithsonian magasin nå for bare $ 12

Denne historien er et utvalg fra desemberutgaven av Smithsonian magazine.

KjøpeEl Kaliouby fremmer affektiv databehandling som det logiske neste trinnet i progresjonen fra tastatur til mus til berøringsskjerm til stemmegjenkjenning. I løpet av våren ga Affectiva ut sitt første kommersielle programvareutviklingssett, som utviklere, som er interessert i brukernes følelsesmessige tilstander i sanntid, kan innlemme i sine egne programmer - for eksempel musikkspillere eller spill- eller datingsapper. Og akkurat i høst lanserte Affectiva Emotion As a Service, et skybasert program som kunder kan laste opp videoer for analyse. Hvem bruker kanskje dette? En kandidat som er i ferd med å bli intervjuet for en jobb, som er bekymret for å virke engstelig eller lei eller til og med smile for mye. Eller et flyselskap som ansetter flyvertinner, med hundrevis av videoapplikasjoner som skal siktes igjennom på leting etter dem som kan klare et overbevisende smil når de sier farvel til passasjerene. (Et ekte smil, som innebærer en sammentrekning av musklene i hjørnene av øynene, kalles et "Duchenne" -smil, oppkalt etter 1800-tallets anatomist. Det motsatte, et tvungent smil som bare bruker munnen, er faktisk noen ganger kalt et "Pan Am" smil.)

Og selvfølgelig er enhetene som kjører denne programvaren, koblet til Internett, slik at informasjonen de samler øyeblikkelig blir samlet, siktet og koblet nettverk på den måten sosiale medierapper identifiserer populære emner eller personligheter. Sammensatt, kanskje, til noe som en Affectiva Mood Index, en numerisk lest om den grove nasjonale lykke, eller delt opp i regioner der smiler eller rynker for øyeblikket er trender.

Affectivas grunnleggende program analyserer ansiktet 20 ganger i sekundet for 46 lokaliserte uttrykk for lykke, tristhet, overraskelse, frykt, sinne, avsky og forakt, pluss interesse og forvirring. (Naomi Shavin / Smithsonian)

Affectivas grunnleggende program analyserer ansiktet 20 ganger i sekundet for 46 lokaliserte uttrykk for lykke, tristhet, overraskelse, frykt, sinne, avsky og forakt, pluss interesse og forvirring. (Naomi Shavin / Smithsonian) Til nå har Affectivas viktigste kunder vært reklame-, markedsførings- og medieselskaper. Programvaren automatiserer prosessen med å drive en fokusgruppe, det tungvint ritualet å samle et dusin mennesker i et rom for å gi sine meninger om et nytt produkt, TV-serie eller annonsekampanje; den registrerer reaksjoner direkte, uten at en deltaker trenger å vri på en skive eller svare på et spørreskjema som svar på en presentasjon. Dessuten utvider programvaren den potensielle fokusgruppen til hele verden, eller i det minste den betydelige brøkdelen av den som har en datamaskin eller mobil enhet som er webcam-aktivert.

Tilbakemeldinger fra Affectivas ubarmhjertige, altoppsiktsvekkende øyne bidro til å forme en nettverks-tv-sitcom, og overga to karakterer til glemmeboken for synden å ikke få seerne til å smile. (El Kaliouby vil ikke identifisere showet eller karakterene.) Programvaren ble brukt til å bygge en "smile sampler", en maskin som delte ut godteribarer til kjøpere som smilte inn i kameraet. Med mer forskning kan det sannsynligvis være nyttig for publikumovervåking i flyplasser, eller for å identifisere potensielle butikkløftere, eller som løgnedetektor.

Men el Kaliouby har motstått disse surreptitious bruksområdene, hvor lukrative de måtte være. Hun tror affektiv databehandling vil endre verden, inkludert, men på ingen måte begrenset til, å selge godteribarer. "Etosetet til selskapet vårt, " sier hun, "er å bruke denne teknologien for å forbedre folks liv og hjelpe dem med å kommunisere bedre, ikke bare for å hjelpe annonsører med å selge flere produkter."

**********

I motsetning til mange teknologiske gründere, ble ikke rik på el Kalioubys opprinnelige agenda. Hun ble født i Kairo for egyptiske foreldre som begge jobber innen teknologi, og studerte datavitenskap ved det amerikanske universitetet i Kairo, der hun ble uteksaminert i 1998, rundt datamaskinene ble kraftige nok til at forskere kunne tenke på å gi dem det som i menneskelige termer er kalt emosjonell intelligens.

Hun fortsatte å studere informatikk ved University of Cambridge, og ankom like etter angrepene på Amerika 11. september 2001. Foreldrene hennes mente hun risikerte å bli arrestert, trakassert eller verre på grunn av arven. Selv om hun hadde på seg et muslimsk hodeplagg inntil for et par år siden, verken i Cambridge, England eller i Cambridge, Massachusetts, hvor hun flyttet i 2006, for å bli med i MIT Media Lab, var hun noen gang bekymret for sin religion eller utseende . "Jeg tror det er fordi jeg smiler mye, " sier hun og smiler.

Den franske anatomisten Duchenne publiserte landemerkeundersøkelser av menneskelige ansiktsuttrykk. (Bridgeman-bilder)

Den franske anatomisten Duchenne publiserte landemerkeundersøkelser av menneskelige ansiktsuttrykk. (Bridgeman-bilder) Mens hun var på Cambridge, hadde hun blitt interessert i problemet med autisme, nærmere bestemt vanskene autistiske barn har med å lese ansiktsuttrykk. Hun foreslo å bygge et “emosjonelt høreapparat” som kan brukes til å lese ansikter og indikere passende oppførsel til brukeren. Først ble avslått for å få tilskudd fra National Science Foundation med den begrunnelse at prosjektet var for vanskelig, hun og kollegene bygde en prototype, bestående av et par briller utstyrt med et bittelitt kamera, blinklys og hodetelefoner, ikke ulikt en tidlig versjon av Google Glass. En annen bevillingssøknad var vellykket, og etter at hun flyttet til MIT jobbet hun og teamet de neste tre årene for å perfeksjonere og teste den på en skole på Rhode Island. El Kaliouby beskriver det som ”et forskningsprosjekt og et vellykket” - de autistiske barna som brukte det, hadde overveldende positive opplevelser - men i 2008, da stipendet ble avsluttet, sto hun overfor et øyeblikk med å regne. Den kommersielle interessen for affektiv databehandling vokste, og hun ønsket å se den utvide og blomstre; Ved å sette sin innsats i å utvikle brillene, vil det begrense seg til en liten bit av potensielle bruksområder. Så sammen med Picard snurret hun av Affectiva, mens hun holdt ut håpet om at et annet selskap ville hente det emosjonelle høreapparatet og bringe det på markedet.

Da Affectiva ble dannet, valgte de håndfulle “teammedlemmene” som utgjorde selskapet hver en verdi de ønsket å legemliggjøre, for eksempel “læring” eller “samfunnsansvar” eller “moro.” Hers, som sjefstrategi og vitenskapsoffiser, var "lidenskap." Det 20-personers selskapet drives som et kvasi-demokrati, med halvårlige møter der ansatte stemmer om prioriteringer de skal forfølge i løpet av det neste halvåret. Kontoret hennes har en tavle dekket med tegninger av den unge datteren til en av kollegene; hun har en 6 år gammel sønn, Adam, og en 12 år gammel datter, Jana, som bor sammen med henne i Boston forsteder (faren deres bor i Egypt). Hennes måte er mild og hensynsfull; en time til et morgenmøte hun tilbyr å bestille en sandwich for en besøkende, selv om hun selv hopper over lunsj. "Det er Ramadan for meg, " sier hun og smiler, "men det er ikke Ramadan for deg."

Hun plasserer besøkende ved et skrivebord, vendt mot en skjerm og et webkamera; programvaren lokaliserer besøkendes ansikt og tegner en boks rundt den på skjermen. Den identifiserer et sett med punkter som skal spores: hjørnene i øynene og munnen, spissen av nesen, og så videre. Tjue ganger hvert sekund ser programvaren etter “action-enheter”, det ofte flyktige muskelspillet i ansiktet. Det er 46 av disse, i henhold til standard klassifiseringssystem, FACS (Facial Action Coding System). De inkluderer inner- og ytre bryggløftere, dimplers, blink, blink og leppepuckers, trakter, pressorer og suger. Affectivas standardprogram prøver rundt 15 av disse når som helst, og analyserer dem for uttrykk for syv grunnleggende følelser: lykke, tristhet, overraskelse, frykt, sinne, avsky og forakt, pluss interesse og forvirring. Smil, og du kan se målet på lykke skyte opp; krølle leppa i en latter og programmet bemerker din avsky.

Eller, mer presist, ditt uttrykk for avsky. Hele forutsetningen for affektiv databehandling hviler på det som utgjør et sprang av tro, at et smil formidler en følelse av lykke, glede eller underholdning. Naturligvis er mennesker i samme posisjon: Vi kan bli lurt av et falskt smil eller forvirret sinne, så vi kan ikke virkelig forvente mer av et dataprogram, i det minste ikke ennå.

Over tid har Affectiva bygget et arkiv med mer enn tre millioner videoer av ansikter, lastet opp av Internett-brukere rekruttert fra rundt 75 land over hele verden. Hundretusenvis av disse er blitt analysert av trente observatører og kodet for FACS-handlingsenheter - et monumentalt foretak, siden videoene i gjennomsnitt er rundt 45 sekunder og det tar omtrent fem ganger så lang tid å behandle. Resultatene fra de menneskelige koderne ble på sin side brukt til å "trene" selskapets algoritmer, som behandlet resten i sanntid. Hele databasen omfatter nå rundt 40 milliarder “følelsesdatapunkter”, en ressurs, el Kaliouby kan skryte av, som skiller Affectiva fra andre selskaper i samme felt, som California-baserte Emotient, sannsynligvis den nærmeste konkurrenten.

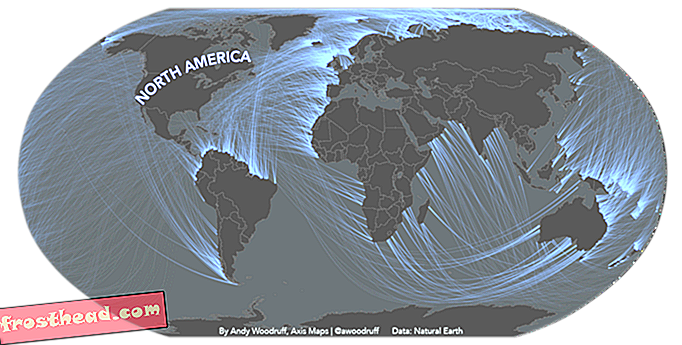

(Kart: 5W Infographics; Kilde: Daniel McDuff, MIT Media Lab, Affectiva)

(Kart: 5W Infographics; Kilde: Daniel McDuff, MIT Media Lab, Affectiva) Daniel McDuff, som begynte i Affectiva fra MIT Media Lab og fungerer som forskningsdirektør, studerer kontinuerlig denne troben for ytterligere innsikt i uttrykk for følelser. Hvordan skiller de seg etter alder, kjønn og kultur? (Kanskje overraskende har McDuff funnet ut at eldre mennesker er mer uttrykksfulle, spesielt av positive følelser, enn yngre.) Kan vi pålitelig måle forakt, forlegenhet, kjedsomhet, angst? Når signaliserer en brynefure forvirring, og når indikerer det konsentrasjon? Hvordan kan vi skille mellom et uttrykk for frykt og et som indikerer overraskelse? (Hint: Handlingsenhet 1, “inner brow raiser”, er markøren for frykt; action unit 2, “ytre brow raiser”, indikerer overraskelse.) Det er, sier han, all grunn til å tro at programmet vil fortsette å bli flinkere til å oppdage uttrykk (selv om det kanskje aldri overvinner den største hindringen av alle: Botox).

På forespørsel ga McDuff programmet et av de store klassiske problemene med følelsesdeteksjon, Mona Lisa, hvis gåtefulle kvasi-smil har fascinert seerne i 500 år. Med advarselen om at programvaren fungerer best på å skifte uttrykk, ikke statiske bilder, rapporterte han at den ikke fant noe bevis på et ekte smil fra La Gioconda, men snarere en kombinasjon av action-enhet 28 (leppetrull) og 24 (lepper presset sammen), noe som muligens antyder noe nivå av ubehag.

**********

"Jeg snakker med deg nå, " sier el Kaliouby, "og ser på deg for å måle din interesse for det jeg sier. Bør jeg bremse og forklare mer? Bør jeg gå til et annet emne? Tenk deg at jeg gir et webinar til en stor gruppe som jeg ikke kan se eller høre. Jeg får ingen tilbakemeldinger, det er ingen måte å si om en vits jobbet eller falt flat, om folk er engasjerte eller kjeder seg. Ville det ikke være flott å få den tilbakemeldingen i sanntid, samlet, fra øyeblikk til øyeblikk når jeg går sammen? ”

Hun spiller en annonse for Jibo, en "sosial robot" som er tilgjengelig for forhåndsbestilling på nettstedet Indiegogo til publikumsfinansiering og utviklet av en tidligere MIT-kollega, Cynthia Breazeal. Ser ut som en høyteknologisk lavalampe, sitter Jibo på et bord og skanner omgivelsene, identifiserer enkeltpersoner etter ansikt og samhandler med dem - videresender meldinger, gir ut påminnelser, ringer rutinemessige telefoner, til og med chatter. Dette er en annen potensiell applikasjon for Affectivas programvare - selskapene er i samtaler - og det er "et veldig spennende prospekt, " sier el Kaliouby.

Spennende for noen, men utsiktene til følelsesbehandlingsroboter er alarmerende for andre. Sherry Turkle, som lenge har studert hvordan mennesker forholder seg til datamaskiner, advarer i sin nye bok, Reclaiming Conversation: The Power of Talk in a Digital Age, om "robotøyeblikket", når maskiner begynner å erstatte menneskelig kameratskap. Turkle mener at forskere som el Kaliouby og hennes team kan gjøre det de sier at de vil. "Dette er alle strålende, begavede mennesker som gjør strålende arbeid, " sier hun. Og hun er enig i at i visse sammenhenger - farlige miljøer, som for eksempel det ytre rom eller rundt tunge maskiner, der du ønsker å verve alle mulige kommunikasjonsmåter - har affektiv databehandling en rolle å spille. "Men neste trinn, " sier hun, "følger ikke i det hele tatt. Neste trinn er: La oss få en robotvenn. Jeg har intervjuet foreldre som er glade for at barna deres snakker med Siri, og jeg tror det ikke tar oss nedover en vei hvor vi vil. Vi definerer oss som mennesker av hvem vi omgås, og det gir ingen mening for meg å danne din følelse av selvtillit i forhold til en maskin. Hvorfor vil du at en datamaskin skal vite om du er trist? ”

Til og med el Kaliouby er tilbøyelig til å være enig i at "vi bruker mer tid enn vi burde med enhetene våre", selvsagt med tanke på sin preteen datter, der blikket låser seg på smarttelefonskjermen.

Men hun ser på trenden mot stadig større tilkoblingsmuligheter som irreversibel, og hun mener at selv om brukere alltid må måtte melde seg inn, kan vi like godt gjøre det beste ut av det. Hun spår at enhetene våre vil ha "en følelsesbrikke og en pakke apper som bruker den på en måte som tilfører nok liv til livene våre som oppveier folks bekymring når det gjelder å dele disse dataene." Hun tegner en analogi til GPS-enheter: Affektiv databehandling kan hjelpe oss med å navigere i emosjonelt rom på samme måte som telefonapper hjelper oss å komme oss rundt i det fysiske rommet. "Alle var bekymret for stedssensorer når de først kom ut: De invaderte privatlivet vårt, de sporet oss hele tiden, " sier hun. ”Først nå ville vi alle gått tapt uten Google Maps på telefonene våre. Jeg tror dette vil være det samme. ”

**********