Alle har hørt om de nye fremskrittene innen kunstig intelligens, og spesielt maskinlæring. Du har også hørt utopiske eller apokalyptiske spådommer om hva disse fremskrittene betyr. De har blitt antatt for å forestille enten udødelighet eller verdens ende, og det er skrevet mye om begge disse mulighetene. Men de mest sofistikerte AI-ene er fremdeles langt fra å kunne løse problemer som menneskelige fireåringer oppnår med letthet. Til tross for det imponerende navnet, består kunstig intelligens i stor grad av teknikker for å oppdage statistiske mønstre i store datasett. Det er mye mer å lære mennesker.

Hvordan kan vi muligens vite så mye om verden rundt oss? Vi lærer enormt mye selv når vi er små barn; fireåringer kjenner allerede til planter og dyr og maskiner; ønsker, tro og følelser; til og med dinosaurer og romskip.

Vitenskapen har utvidet kunnskapen vår om verden til den utenkelig store og uendelig liten, til kanten av universet og tidens begynnelse. Og vi bruker den kunnskapen til å lage nye klassifiseringer og spådommer, forestille oss nye muligheter og få nye ting til å skje i verden. Men alt som når noen av oss fra verden er en strøm av fotoner som treffer netthinnene våre og forstyrrelser i luft ved trommehinnene våre. Hvordan lærer vi så mye om verden når bevisene vi har er så begrensede? Og hvordan gjør vi alt dette med de få kilo grå goo som sitter bak øynene våre?

Det beste svaret så langt er at hjernen vår utfører beregninger på konkrete, rotete data som kommer til sansene våre, og disse beregningene gir nøyaktige fremstillinger av verden. Representasjonene ser ut til å være strukturerte, abstrakte og hierarkiske; de inkluderer oppfatningen av tredimensjonale objekter, grammatikkene som ligger til grunn for språket, og mentale kapasiteter som "sinnsteori", som lar oss forstå hva andre mennesker tror. Disse representasjonene lar oss lage et bredt spekter av nye spådommer og forestille oss mange nye muligheter på en utpreget kreativ menneskelig måte.

Denne typen læring er ikke den eneste typen intelligens, men den er spesielt viktig for mennesker. Og det er den typen intelligens som er en spesialitet for små barn. Selv om barn er dramatisk dårlige til å planlegge og ta beslutninger, er de de beste elevene i universet. Mye av prosessen med å gjøre data om til teorier skjer før vi er fem.

Siden Aristoteles og Platon har det vært to grunnleggende måter å ta opp problemet med hvordan vi vet hva vi vet, og de er fremdeles de viktigste tilnærmingene i maskinlæring. Aristoteles nærmet seg problemet nedenfra og opp: Start med sanser - strømmen av fotoner og luftvibrasjoner (eller piksler eller lydprøver på et digitalt bilde eller opptak) - og se om du kan trekke ut mønstre fra dem. Denne tilnærmingen ble videreført av så klassiske foreningsfolk som filosofer David Hume og JS Mill og senere av atferdspsykologer, som Pavlov og BF Skinner. På dette synspunktet er representasjoners abstraksjon og hierarkiske struktur noe av en illusjon, eller i det minste en epifenomenon. Alt arbeidet kan utføres ved assosiasjon og mønsterdeteksjon - spesielt hvis det er nok data.

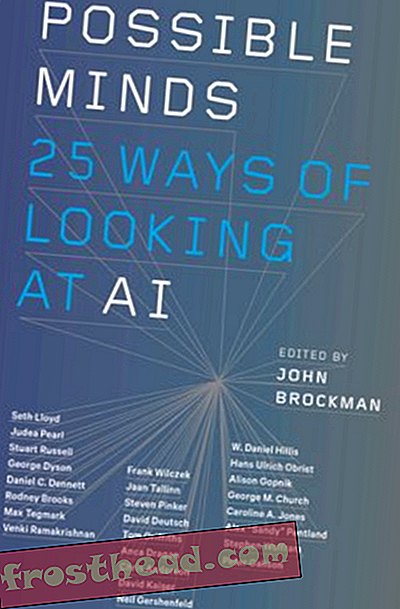

Mulige tanker: 25 måter å se på AI på

Vitenskapens verdensarmatur John Brockman samler tjuefem av de viktigste vitenskapelige sinnene, mennesker som har tenkt på feltet kunstig intelligens i de fleste av sine karrierer, for en enestående undersøkelse rundt bordet om sinn, tenking, intelligens og hva det vil si vær menneskelig.

KjøpeOver tid har det vært en sagbrudd mellom denne bottom-up tilnærmingen til læringsmysteriet og Platons alternativ, ovenfra og ned. Kanskje får vi abstrakt kunnskap fra konkrete data fordi vi allerede vet mye, og spesielt fordi vi allerede har en rekke grunnleggende abstrakte begreper, takket være evolusjonen. Som forskere kan vi bruke disse begrepene til å formulere hypoteser om verden. I stedet for å prøve å trekke ut mønstre fra rå data, kan vi gjøre forutsigelser om hvordan dataene skal se ut hvis disse hypotesene stemmer. Sammen med Platon tok slike "rasjonalistiske" filosofer og psykologer som Descartes og Noam Chomsky denne tilnærmingen.

Her er et hverdagseksempel som illustrerer forskjellen mellom de to metodene: å løse spam-pesten. Dataene består av en lang, usortert liste over meldinger i innboksen. Realiteten er at noen av disse meldingene er ekte og andre er spam. Hvordan kan du bruke dataene til å skille mellom dem?

Tenk på bottom-up-teknikken først. Du legger merke til at spam-meldingene har en tendens til å ha spesielle funksjoner: en lang liste over adressater, opprinnelse i Nigeria, referanser til millioner dollar premier, eller Viagra. Problemet er at perfekt nyttige meldinger kan ha disse funksjonene også. Hvis du har sett på nok eksempler på e-postmeldinger med spam og ikke-spam, kan du se ikke bare at spam-e-postmeldinger har en tendens til å ha disse funksjonene, men at funksjonene har en tendens til å gå sammen på spesielle måter (Nigeria pluss en million dollar stave problemer). Det kan faktisk være noen subtile korrelasjoner på høyere nivå som diskriminerer spam-meldingene fra de nyttige - et bestemt mønster av stavefeil og IP-adresser, si. Hvis du oppdager disse mønstrene, kan du filtrere ut søppelen.

De nederst oppe maskinlæringsteknikkene gjør nettopp dette. Eleven får millioner av eksempler, hver med et sett med funksjoner og hver merket som spam (eller en annen kategori) eller ikke. Datamaskinen kan trekke ut mønsteret med funksjoner som skiller de to, selv om det er ganske subtilt.

Hva med den ovenfra og ned tilnærmingen? Jeg får en e-post fra redaktøren av Journal of Clinical Biology . Den refererer til et av papirene mine og sier at de gjerne vil publisere en artikkel av meg. Ingen Nigeria, ingen Viagra, ingen millioner dollar; e-posten har ikke noen av funksjonene til spam. Men ved å bruke det jeg allerede vet, og tenke på en abstrakt måte om prosessen som produserer spam, kan jeg finne ut at denne e-posten er mistenkelig:

1. Jeg vet at spammere prøver å hente ut penger fra mennesker ved å appellere til menneskelig grådighet.

2. Jeg vet også at legitime "open access" -tidsskrifter har begynt å dekke kostnadene ved å belaste forfattere i stedet for abonnenter, og at jeg ikke praktiserer noe som klinisk biologi.

Sett alt sammen, og jeg kan produsere en god ny hypotese om hvor e-posten kom fra. Den er designet for å suge akademikere til å betale for å "publisere" en artikkel i et falskt tidsskrift. E-postadressen var et resultat av den samme tvilsomme prosessen som de andre spam-e-postene, selv om den ikke lignet på dem. Jeg kan trekke denne konklusjonen fra bare ett eksempel, og jeg kan fortsette å teste hypotesen min ytterligere, utover hva som helst i selve e-posten, ved å google “redaktøren.”

Datamessig begynte jeg med en "generativ modell" som inkluderer abstrakte begreper som grådighet og bedrag og beskriver prosessen som produserer e-post-svindel. Det lar meg gjenkjenne den klassiske nigerianske e-post-spam, men den lar meg også forestille meg mange forskjellige typer mulig spam. Når jeg får journalen e-post, kan jeg jobbe bakover: "Dette virker som den typen e-post som ville kommet ut av en spam-genererende prosess."

Den nye spenningen rundt AI kommer fordi AI-forskere nylig har produsert kraftige og effektive versjoner av begge disse læringsmetodene. Men det er ingenting dypt nytt med metodene i seg selv.

Deep-down Deep Learning

På 1980-tallet tenkte datamaskinforskere en genial måte å få datamaskiner til å oppdage mønstre i data: tilkoblingsnett, eller nevralt nettverk, arkitektur (den “nevrale” delen var, og er fremdeles, metaforisk). Tilnærmingen falt i doldrums på 1990-tallet, men har nylig blitt gjenopplivet med kraftige "deep-learning" metoder som Googles DeepMind.

Du kan for eksempel gi et dybdelæringsprogram et knippe internettbilder med navnet "katt", andre merket "hus" og så videre. Programmet kan oppdage mønstrene som skiller de to bildesettene og bruke den informasjonen til å merke nye bilder riktig. Noen typer maskinlæring, kalt uovervåket læring, kan oppdage mønstre i data uten merkelapper i det hele tatt; de ser ganske enkelt etter klynger av funksjoner - det forskere kaller en faktoranalyse. I dyplæringsmaskinene gjentas disse prosessene på forskjellige nivåer. Noen programmer kan til og med oppdage relevante funksjoner fra rå data om piksler eller lyder; datamaskinen kan begynne med å oppdage mønstrene i det rå bildet som tilsvarer kanter og linjer og deretter finne mønstrene i de mønstrene som tilsvarer ansikter, og så videre.

En annen bottom-up-teknikk med lang historie er forsterkningslæring. På 1950-tallet, som BF Skinner bygger på arbeidet til John Watson, berømte programmerte duer for å utføre detaljerte handlinger - til og med å lede luft-lanserte raketter til sine mål (et urovekkende ekko av nyere AI) ved å gi dem en spesiell plan for belønning og straff . Den essensielle ideen var at handlinger som ble belønnet ville bli gjentatt og at de som ble straffet, ikke ville før ønsket oppførsel ble oppnådd. Selv på Skinners dag kan denne enkle prosessen, gjentatte ganger om igjen, føre til kompleks oppførsel. Datamaskiner er designet for å utføre enkle operasjoner igjen og igjen i en skala som dverger menneskets fantasi, og beregningssystemer kan lære bemerkelsesverdig komplekse ferdigheter på denne måten.

For eksempel brukte forskere ved Googles DeepMind en kombinasjon av dyp læring og forsterkende læring for å lære en datamaskin å spille Atari videospill. Datamaskinen visste ingenting om hvordan spillene fungerte. Det begynte med å handle tilfeldig og fikk kun informasjon om hvordan skjermen så ut i hvert øyeblikk og hvor bra den hadde scoret. Dyp læring bidro til å tolke funksjonene på skjermen, og forsterkende læring belønnet systemet for høyere score. Datamaskinen ble veldig god til å spille flere av spillene, men den bombet også fullstendig på andre som var like enkle for mennesker å mestre.

En lignende kombinasjon av dyp læring og forsterkende læring har muliggjort suksessen til DeepMinds AlphaZero, et program som klarte å slå menneskelige spillere på både sjakk og Go, utstyrt med bare en grunnleggende kunnskap om spillereglene og noen planleggingsevner. AlphaZero har en annen interessant egenskap: Det fungerer ved å spille hundrevis av millioner spill mot seg selv. Når den gjør det, beskjærer den feil som førte til tap, og den gjentar og utdyper strategier som førte til seire. Slike systemer, og andre som involverer teknikker som kalles generative adversarial nettverk, genererer data i tillegg til å observere data.

Når du har regnekraften til å bruke disse teknikkene på veldig store datasett eller millioner av e-postmeldinger, Instagram-bilder eller taleopptak, kan du løse problemer som virket veldig vanskelig før. Det er kilden til mye av spenningen innen informatikk. Men det er verdt å huske at disse problemene - som å erkjenne at et bilde er en katt eller et snakket ord er Siri - er trivielle for en menneskelig pjokk. En av de mest interessante oppdagelsene innen informatikk er at problemer som er enkle for oss (som å identifisere katter) er vanskelig for datamaskiner - mye vanskeligere enn å spille sjakk eller Go. Datamaskiner trenger millioner av eksempler for å kategorisere objekter som vi kan kategorisere med bare noen få. Disse bottom-up systemene kan generaliseres til nye eksempler; de kan merke et nytt bilde som en katt ganske nøyaktig over alt. Men de gjør det på forskjellige måter enn hvordan folk generaliserer. Noen bilder som nesten er identiske med et kattebilde, blir ikke identifisert av oss som katter i det hele tatt. Andre som ser ut som en tilfeldig uskarphet vil være.

Top-Down Bayesian modeller

Top-down tilnærmingen spilte en stor rolle i tidlig AI, og på 2000-tallet opplevde den også en vekkelse, i form av sannsynlige eller bayesiske, generative modeller.

De tidlige forsøkene på å bruke denne tilnærmingen sto overfor to typer problemer. For det første kan de fleste bevismønstre i prinsippet forklares med mange forskjellige hypoteser: Det er mulig at e-postmeldingen til min journal er ekte, den virker ikke sannsynlig. For det andre, hvor kommer konseptene som de generative modellene bruker fra i utgangspunktet? Platon og Chomsky sa at du ble født med dem. Men hvordan kan vi forklare hvordan vi lærer de siste vitenskapsbegrepene? Eller hvordan til og med små barn forstår om dinosaurer og rakettskip?

Bayesiske modeller kombinerer generative modeller og hypotesetesting med sannsynlighetsteori, og de adresserer disse to problemene. En Bayesian-modell lar deg beregne hvor sannsynlig det er at en bestemt hypotese er sann, gitt dataene. Og ved å lage små, men systematiske, finjusteringer til modellene vi allerede har, og teste dem mot dataene, kan vi noen ganger lage nye konsepter og modeller fra gamle. Men disse fordelene oppveies av andre problemer. De bayesiske teknikkene kan hjelpe deg med å velge hvilke av to hypoteser som er mer sannsynlig, men det er nesten alltid et enormt antall mulige hypoteser, og ingen systemer kan vurdere dem alle effektivt. Hvordan bestemmer du hvilke hypoteser som er verdt å teste i utgangspunktet?

Brenden Lake ved NYU og kolleger har brukt denne typen ovenfra og ned-metoder for å løse et annet problem som er lett for folk, men som er ekstremt vanskelig for datamaskiner: gjenkjenne ukjente håndskrevne tegn. Se på et tegn på en japansk rull. Selv om du aldri har sett den før, kan du sannsynligvis fortelle om den ligner eller er forskjellig fra et tegn på en annen japansk rull. Du kan sannsynligvis tegne den og til og med designe en falsk japansk karakter basert på den du ser - en som vil se ganske annerledes ut enn en koreansk eller russisk karakter.

Bottom-up metoden for å gjenkjenne håndskrevne tegn er å gi datamaskinen tusenvis av eksempler på hver enkelt og la den trekke frem de fremtredende funksjonene. I stedet har Lake et al. ga programmet en generell modell for hvordan du tegner en karakter: Et slag går enten til høyre eller venstre; etter at du er ferdig med en, begynner du en annen; og så videre. Når programmet så en spesiell karakter, kunne det utlede rekkefølgen av slag som mest sannsynlig ville ha ført til det - akkurat som jeg konkluderte med at spamprosessen førte til min tvilsomme e-post. Da kunne den bedømme om en ny karakter sannsynligvis ville være resultatet av den sekvensen eller fra en annen, og den kunne produsere et lignende sett med slag selv. Programmet fungerte mye bedre enn et dybdelæringsprogram som ble brukt på nøyaktig de samme dataene, og det speilet nøye ytelsen til mennesker.

Disse to tilnærmingene til maskinlæring har komplementære styrker og svakheter. I bottom-up-tilnærmingen trenger ikke programmet mye kunnskap til å begynne med, men det trenger mye data, og det kan generaliseres bare på en begrenset måte. I ovenfra og ned-tilnærmingen kan programmet lære av bare noen få eksempler og lage mye bredere og mer varierte generaliseringer, men du må bygge mye mer inn i det til å begynne med. En rekke etterforskere prøver for tiden å kombinere de to tilnærmingene, ved å bruke dyp læring for å implementere Bayesian inferens.

Den nylige suksessen til AI er delvis et resultat av utvidelser av de gamle ideene. Men det har mer å gjøre med det faktum at vi, takket være Internett, har mye mer data, og takket være Mores lov har vi mye mer regnekraft til å bruke på disse dataene. Dessuten er et ikke verdsatt faktum at dataene vi gjør allerede har blitt sortert og behandlet av mennesker. Kattebildene som er lagt ut på nettet er kanoniske kattebilder - bilder som mennesker allerede har valgt som "gode" bilder. Google Translate fungerer fordi den drar nytte av millioner av menneskelige oversettelser og generaliserer dem til et nytt stykke tekst, i stedet for å virkelig forstå setningene selv.

Men det virkelig bemerkelsesverdige med menneskebarn er at de på en eller annen måte kombinerer de beste funksjonene ved hver tilnærming og deretter går langt utover dem. I løpet av de siste femten årene har utviklingsarbeidere undersøkt hvordan barn lærer struktur fra data. Fireåringer kan lære ved å ta bare ett eller to eksempler på data, slik et top-down-system gjør, og generalisere til veldig forskjellige konsepter. Men de kan også lære nye konsepter og modeller fra selve dataene, slik et bottom-up-system gjør.

I laboratoriet vårt for eksempel gir vi små barn en "blikkedetektor" - en ny maskin å finne ut av, en de aldri har sett før. Det er en boks som lyser og spiller musikk når du legger visse gjenstander på den, men ikke andre. Vi gir barn bare ett eller to eksempler på hvordan maskinen fungerer, og viser dem at for eksempel to røde blokker får den til å gå, mens en grønn-gul kombinasjon ikke gjør det. Selv atten måneder gamle tenker umiddelbart på det generelle prinsippet at de to objektene må være de samme for å få det til å gå, og de generaliserer dette prinsippet til nye eksempler: For eksempel vil de velge to objekter som har samme form å lage maskinarbeidet. I andre eksperimenter har vi vist at barn til og med kan finne ut at en eller annen skjult usynlig egenskap får maskinen til å gå, eller at maskinen fungerer etter et abstrakt, logisk prinsipp.

Du kan også vise dette i barns hverdagslæring. Små barn lærer raskt abstrakte intuitive teorier om biologi, fysikk og psykologi på samme måte som voksne forskere gjør, selv med relativt lite data.

De bemerkelsesverdige maskinlæringsresultatene til de nylige AI-systemene, både nedenfra og opp og ned, foregår i et smalt og godt definert rom med hypoteser og konsepter - et presist sett med spillbrikker og trekk, et forhåndsbestemt sett med bilder . I kontrast til dette, forandrer både barn og forskere noen ganger konseptene sine på radikale måter og utfører paradigmeskift i stedet for bare å finjustere konseptene de allerede har.

Fireåringer kan øyeblikkelig kjenne igjen katter og forstå ord, men de kan også lage kreative og overraskende nye slutninger som går langt utover deres erfaring. Mitt eget barnebarn forklarte nylig for eksempel at hvis en voksen vil bli barn igjen, burde han prøve å ikke spise sunne grønnsaker, siden sunne grønnsaker får et barn til å vokse til voksen. Denne typen hypotese, en plausibel en som ingen voksne noensinne vil underholde, er karakteristisk for små barn. Faktisk har kollegaene mine og jeg systematisk vist at førskolebarn er flinkere til å komme med usannsynlige hypoteser enn eldre barn og voksne. Vi aner nesten ikke hvordan denne typen kreativ læring og innovasjon er mulig.

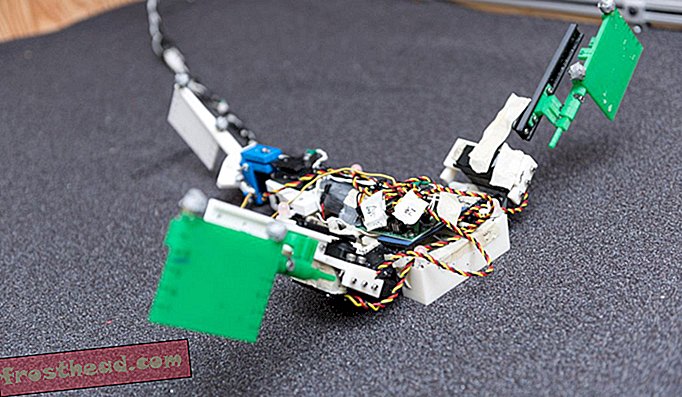

Å se på hva barn gjør, kan imidlertid gi programmerere nyttige tips om veibeskrivelser for datamaskinlæring. To trekk ved barns læring er spesielt slående. Barn er aktive elever; de ikke bare passivt suge opp data som AIs gjør. Akkurat som forskere eksperimenterer, er barn i egenskap av motiverte til å hente ut informasjon fra verden rundt seg gjennom deres uendelige lek og utforskning. Nyere studier viser at denne utforskningen er mer systematisk enn den ser ut og er godt tilpasset for å finne overbevisende bevis for å støtte hypotesedannelse og teorivalg. Å bygge nysgjerrighet i maskiner og la dem aktivt samhandle med verden kan være en vei til mer realistisk og omfattende læring.

For det andre er barn, i motsetning til eksisterende AIer, sosiale og kulturelle elever. Mennesker lærer ikke isolert, men benytter seg av tidligere generasjons akkumulerte visdom. Nyere studier viser at også førskolebarn lærer gjennom imitasjon og ved å lytte til andres vitnesbyrd. Men de følger ikke bare passivt lærerne sine. I stedet tar de inn informasjon fra andre på en bemerkelsesverdig subtil og sensitiv måte, og gjør komplekse konklusjoner om hvor informasjonen kommer fra og hvor pålitelig den er og systematisk integrerer sine egne erfaringer med det de hører.

“Kunstig intelligens” og “maskinlæring” høres skummelt ut. Og på noen måter er de det. Disse systemene brukes for å kontrollere våpen, for eksempel, og vi burde virkelig være redde for det. Likevel kan naturlig dumhet skape mye mer ødeleggelse enn kunstig intelligens; vi mennesker må være mye smartere enn vi har vært tidligere for å regulere de nye teknologiene på riktig måte. Men det er ikke mye grunnlag for verken den apokalyptiske eller den utopiske visjonen om AIs å erstatte mennesker. Inntil vi løser det grunnleggende paradokset for læring, vil de beste kunstige intelligensene ikke være i stand til å konkurrere med den gjennomsnittlige menneskelige fireåringen.

Fra den kommende samlingen MULIGE MINDS: 25 Ways of Looking at AI, redigert av John Brockman. Publisert etter avtale med Penguin Press, medlem av Penguin Random House LLC. Copyright © 2019 John Brockman.